Сегодня рассмотрим подробно самый важный процесс, без которого остальные процессы SEO-продвижения не работают. Мы поговорим об индексации, принципах её работы, важности, отличиях в Google и Яндекс. Также расскажем, как проиндексировать сайт любого размера и улучшить его качество.

Индексация сайта и почему она так важна

Как работает поисковая система?

Чтобы понять, что такое индексация, нужно сначала разобраться, как работают поисковые системы и почему их можно считать библиотеками Интернета.

Поисковая система — это множество серверов, на которых хранятся структурированные данные о миллионах, а возможно и миллиардах документов в Интернете. То есть когда мы запрашиваем какую-либо информацию в Google или Яндексе, мы ищем не по самому интернету, а по их поисковой базе.

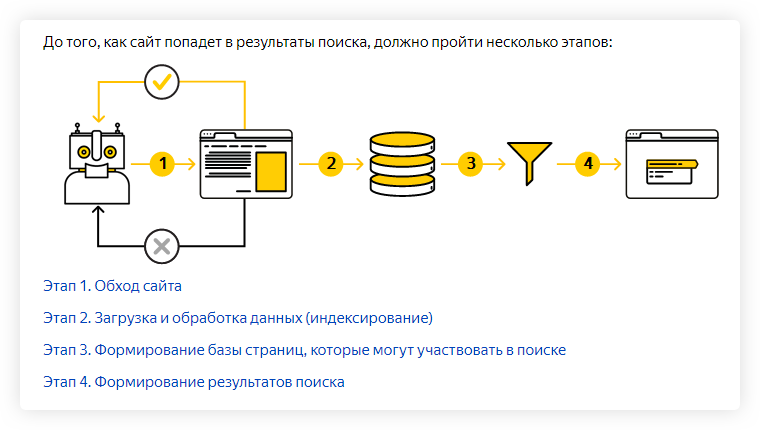

Чтобы документ попал в эту базу, он должен быть известен поисковому роботу (краулер — от англ. crawler, бот, паук). Робот узнаёт о новых сайтах и страницах следующими способами:

- внешние и внутренние ссылки,

- собственные браузеры (Google Chrome, Яндекс Браузер),

- тулбары, или панели инструментов,

- собственные инструменты (поговорим о них ниже),

- карта сайта (sitemap).

Когда поисковой робот узнал о новом документе, он заносит его в расписание проверок и затем, если документ доступен для обхода, робот выкачивает преимущественно текстовую информацию (этот процесс ещё называют краулингом) и передаёт индексирующему роботу. После этого документ, сайт или страница могут участвовать в поиске.

Почему мы говорим о документе? Потому что робот умеет индексировать не только HTML-страницы, но и другие форматы (справка Яндекса и Google).

Что такое индексация?

Попробуем дать собственное определение этому понятию. Индексация сайта — это процесс получения, обработки, структуризации и хранения преимущественно текстовой информации о страницах сайта в поисковой базе. О получении этой информации мы уже рассказали. Под обработкой подразумеваем, что информация каждой страницы собрана и очищена от лишнего (картинки и графика, HTML-теги и т.д.). Но важнее всего остановиться на структуризации данных.

Вся полученная текстовая информация делится на отдельные слова, которые группируются в алфавитном порядке. Эти слова приводятся к их начальной форме. Алгоритмы каждой поисковой системы разнятся, поэтому мы не можем точно знать обо всех тонкостях процесса, но сам процесс называется машинной морфологией. К начальным формам слов робот добавляет адрес страницы и количество упоминаний на ней.

Почему так важна индексация?

Ответ прост: чем больше ваших страниц в поисковой базе (проиндексированы), тем больше возможностей для показа в поисковой выдаче. Выражаясь ещё проще, если вы в базе, вас могут найти.

Конечно, всё, что мы здесь описали, значительно упрощено для понимания, а некоторые тонкости и нюансы опущены. Например, логичен вопрос: вы говорите о возможностях, но не говорите о гарантиях показа. Дело в том, что индексация не гарантирует показ страниц вашего сайта, ведь после неё каждый раз включается процесс ранжирования документов по каждому отдельному запросу.

Ранжирование — это распределение страниц, имеющихся в поисковой базе, в порядке приоритета и релевантности для запросов пользователей. Если проще, то документы ваших конкурентов могут быть качественнее и релевантнее (более подходящими) по мнению поисковой системы, чем ваши. Поэтому даже если страницы вашего сайта будут находиться в индексе, не факт, что они будут показываться в поиске. А если и будут, то нет гарантий, что на 1–2 странице.

Тезис: чем больше страниц сайта проиндексированы, тем больше шансов получить трафик.

Что может мешать индексации?

Самая главная причина — робот не знает о наличии страницы либо сайта. Как мы обозначили выше, у краулера ограничены способы нахождения новых страниц. Учитывайте это и используйте все доступные меры:

- Добавьте свой сайт во все инструменты Яндекса и Google.

- Создайте и обновляйте карту сайта (sitemap.xml).

- Используйте родные браузеры поисковиков.

- Делайте ссылки со старых страниц на новые.

- Разумно используйте возможности внешних ссылок.

Помешать индексации могут следующие причины:

- некачественный контент;

- страница дублирует содержание другой;

- на сайте или странице обнаружены нарушения (санкции ПС);

- страница недоступна (код 4xx или 5xx);

- настроен 3xx-редирект (редирект — это перенаправление с одной страницы на другую);

- запрет индексации в robots.txt;

- метатег robots со значением noindex или HTTP-заголовок X-Robots-Tag;

- медленная загрузка страницы и/или сайта;

- атрибут rel=canonical на другую страницу (проиндексирует каноническую);

- длина URL страницы превышает 1024 символов (Яндекс);

- документ больше 10 мб (Яндекс);

- количество ссылок на одной странице превышает 2000–3000 (Google).

Нюанс №1: для Яндекс robots.txt — важный документ, а для Google рекомендательный. То есть, если робот сочтёт страницу полезной для пользователей, он будет игнорировать запреты в файле. Для запрета индексации страницы в Гугле лучше использовать метатег robots или HTTP-заголовок X-Robots-Tag.

Нюанс №2: 3xx-редирект и атрибут rel=canonical не запрещают индексацию страницы напрямую, но указывают, что она вторична, в отличие от страницы редиректа или канонической.

Нюанс №3: указание канонической страницы не всегда спасает владельца сайта, так как Google может по своему усмотрению выбирать канонические страницы и игнорировать атрибут rel=canonical.

Краулинговый бюджет

Количество новых документов в Интернете постоянно растёт, а технологические мощности поисковых гигантов всё же ограничены. Поэтому робот решает, сколько страниц одного сайта будет индексировать за раз. Это и называют краулинговым бюджетом.

Он зависит от количества и качества страниц, частоты их обновления, типа самого сайта (маркетплейс, новостник, небольшой сайт), популярности и авторитетности ресурса. Важно отметить, что краулинговый бюджет — это не постоянная величина, и он может изменяться.

Напрямую управлять как индексированием, так и бюджетом сканирования вы не можете, но способствовать этим процессам точно можно. Об этом подробнее поговорим в разделе «Как управлять индексацией».

Индексация сайта в Google и Яндекс

Принципы индексации у этих поисковых систем преимущественно одинаковые: краулинг → очистка → индексация → ранжирование. Но различия можно найти, поэтому расскажем о тех, которые известны.

Индексация в Google

Самое главное отличие — Google лучше ориентируется в англоязычном сегменте, то есть лучше воспринимает текст и запрос пользователя на английском. Разница на момент 2020, думается, незначительная, но учитывать стоит.

У Гугла 2 основных типа роботов: для мобильных сайтов и для десктопных. Новые сайты индексируются мобильными роботами и приоритет отдан мобильным версиям сайта, согласно алгоритму mobile-first индекс.

Скорость индексации обычно выше, чем у Яндекса: на 1 страницу уходит неделя или меньше. Индекс обновляется постоянно, а некачественные страницы не удаляются из него, но при этом и не показываются пользователям.

Индексация в Яндексе

У Яндекса тоже 2 типа роботов: основной и быстрый (Orange). Основной робот занимается индексацией всего интернета, а быстрый отвечает за поиск самых свежих документов, чтобы информация была доступна как можно быстрее (от нескольких минут до пары секунд).

Обновление индекса происходит раз в несколько дней ночью, когда нагрузки на серверы меньше. Процесс индексирования сайта обычно занимает от недели до месяца, а некачественные страницы удаляются из индекса.

Как проверить индексацию?

Уточним сразу пару моментов. Индексацию нужно проверять как в Google, так и в Яндексе. Более того, вы должны знать изначальное количество страниц на сайте. Это можно сделать с помощью краулеров типа Xenu, Screaming Frog, Netpeak Spider и других.

Как проверить индексацию:

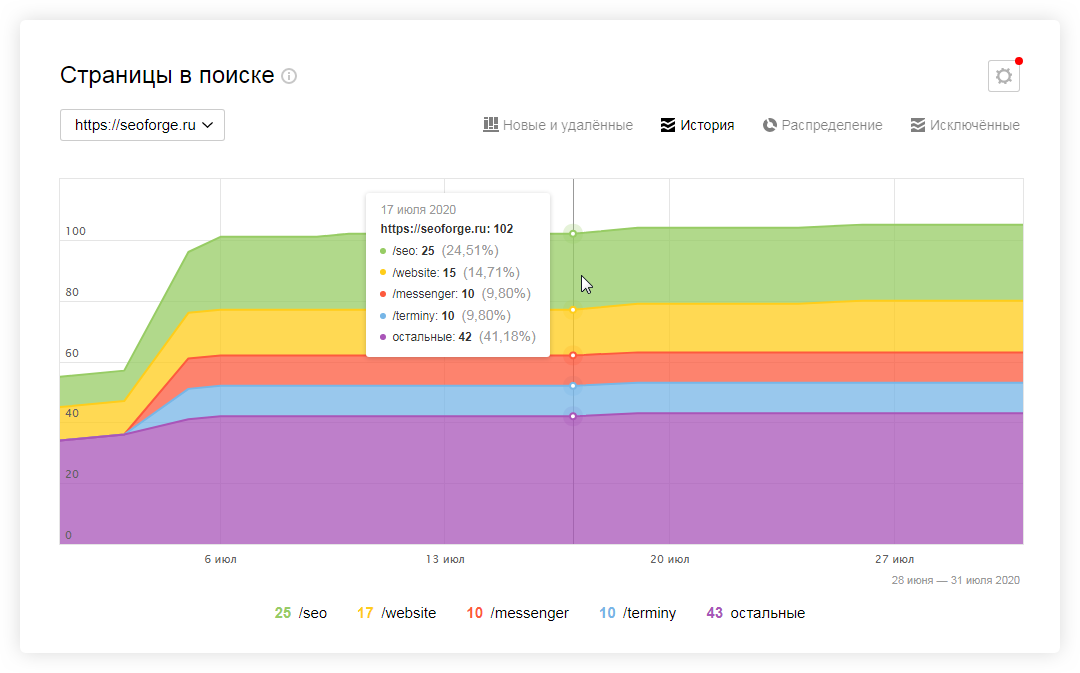

- Инструменты Яндекс Вебмастер и Google Search Console. В Вебмастере это Индексирование → Страницы поиска (отдельные страницы смотрите в инструменте «Проверить статус URL»). В Search Console откройте отчёт Покрытие → Страницы без ошибок (индексацию отдельных страниц ищите в Проверке URL).

- Используйте оператор site. В поисковой строке Яндекса и Google введите site:name.com, где name — домен сайта. Под строкой поиска справа будет указано количество проиндексированных страниц. Если разница в количестве больше 10%, у вас проблемы с индексацией.

- RDS Bar и другие сервисы. RDS Bar — это бесплатный плагин для браузера. В нём вы узнаете не только количество проиндексированных страниц, но и получите другую полезную информацию. Также автор статьи советует воспользоваться сервисом a.pr-cy. Он позволяет провести хороший первичный аудит сайта и уже в самом начале выявить основные проблемы.

Индексация сайта в поиске

Теперь, когда мы рассказали, что такое индексация, почему она так важна и как её проверить, приступим к практике.

Как ускорить индексацию?

Мы писали выше, что управлять индексацией, что бы кто не говорил, вы не можете. Но повлиять на процесс или даже ускорить возможно.

Советы по ускорению индексации

- Обязательно добавьте сайт во все сервисы Яндекса и Google, особенно в Яндекс Вебмастер и Google Search Console.

- Создайте sitemap.xml, поместите карту в корень сайта и постоянно обновляйте.

- Следите за robots.txt и исключайте ненужные страницы (об этом ниже).

- Выберите надёжный и быстрый хостинг, чтобы робот мог беспрепятственно индексировать содержимое сайта.

- Используйте инструменты Яндекс Вебмастера (Индексирование → Переобход страниц) и Google Search Console (Проверка URL → Запросить индексирование). Способ идеально подходит для работы с отдельными страницами.

- Если ваша CMS любит создавать дубли (например, Битрикс), то используйте атрибут rel=canonical.

- Автоматизируйте создание новых ссылок со старых страниц. Как вариант, можно сделать блок на главной с новыми товарами или статьями.

- Ведите соцсети и анонсируйте новые товары, услуги, страницы. Замечено, что ссылки с соцсетей могут ускорить процесс.

- Создавайте качественный контент на каждой странице. Под качественным контентом мы понимаем актуальную, релевантную и уникальную информацию для пользователей.

- Работайте над структурой сайта и делайте её удобной и понятной пользователю. Помните о правиле 3 кликов: это оптимальное количество действий для пользователя.

- Проверяйте периодически сайт на вирусы и санкции поисковых систем. В Яндекс Вебмастере раздел Диагностика → Безопасность и нарушения, в Google Search Console — раздел Проблемы безопасности и меры, принятые вручную.

- Улучшайте свой ссылочный профиль и пишите анонсы на других сайтах (в рамках правил поисковых систем).

- Используйте родные браузеры (Chrome, Яндекс Браузер) и заходите на новые страницы с них.

Как запретить индексацию?

Выше мы рассмотрели основные способы, как ускорить индексацию, и рассказали, что такое краулинговый бюджет и почему он ограничен для каждого сайта. Поэтому чтобы его не тратить зря, советуем закрывать от индексации служебные и технические страницы, кабинеты пользователей и конфиденциальную информацию, а также страницы в разработке и дубли.

3 основных способа запретить индексацию:

- Директива Disallow в файле robots. Мы писали, что такой запрет может не сработать в отдельных случаях. Тем не менее это основной способ запрета индексации.

- В коде страницы указать метатег robots с директивой noindex (для текста) и/или nofollow (для ссылок). Хорошо подходит для запрета индексации отдельных страниц.

- Настроить HTTP-заголовок X-Robots-Tag с директивой noindex и/или nofollow. Лучше всего подходит для закрытия индексации не HTML-файлов (PDF, изображения, видео и другие).

Индексация многостраничных сайтов

Отдельным столпом стоит работа с краулинговым бюджетом для многостраничных сайтов: маркетплейсы, агрегаторы, интернет-магазины, новостники, форумы и другие. Скажем по секрету, что владельцам небольших сайтов (до 1000 страниц) о бюджете краулинга можно волноваться меньше. А вот владельцам многостраничников придётся нелегко.

Как улучшить индексацию многостраничного сайта:

- Используйте все наши советы по улучшению индексации на полную мощь.

- Максимальное внимание уделите улучшению структуры и навигации и обновлению карты сайта.

- Структура сайта должна быть проста и понятна, охватывать весь спектр ключевых запросов, а каждая страница сайта в идеале должна быть доступна в 3–4 клика. Для этого используйте дополнительные блоки на главной странице и в разделах.

- Хорошо работает облако тегов: с помощью него часто получается продвигать категории, улучшать навигацию и полно охватывать семантику.

- Для многостраничных сайтов действительно важно постоянно обновлять sitemap.xml. Зачастую в таких случаях карту делят на несколько частей, чтобы охватить весь список страниц.

- Настройте маски (автоматические шаблоны) метатегов для новых страниц в категориях и каталогах.

- Скорее всего, вам не обойтись без команды профессионалов, которые смогут обеспечить техподдержку, производство контента и SEO-продвижение.

Эта статья уже проиндексирована

Надеемся, что материал получился максимально полезным и интересным, а мы ответили на все вопросы, касающиеся индексации. Тема сложная, и сразу во всём не разобраться, но уверяем, что, если последуете нашим советам, вы только улучшите свой сайт и его качество.

Если всё-таки вопросы остались, задавайте их нам!